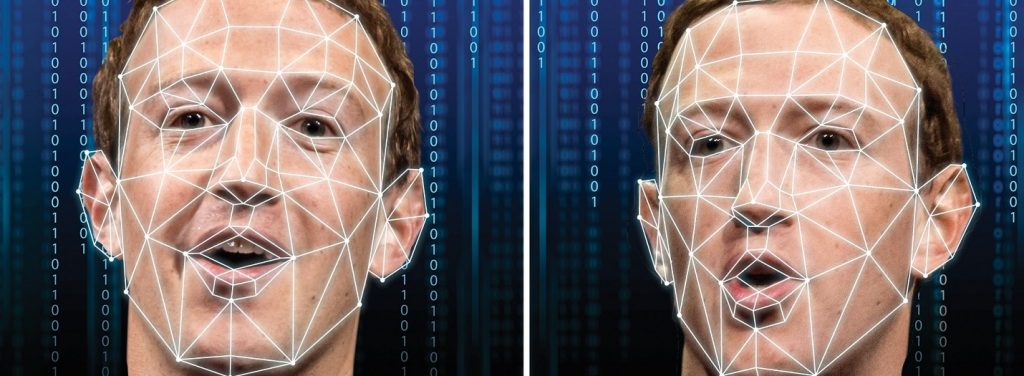

В последнее время часто происходят дискуссии о допустимости так называемых дипфейков, то есть образов, искусственно созданных нейросетями. И последние исследования показывают, что дипфейки действительно представляют реальную опасность.

Дело в том, что отличить лицо настоящего человека, от лица, которое сгенерированно нейросетями практически невозможно. Это выяснила в ходе эксперимента группа американский и английских ученых. Более того, оказалось, что лица «не настоящих» людей вызывают большее доверия.

Читайте больше о технологии дипфейков в статье «Как просто оживить фотографии»

Во время исследования группе из 315 добровольцев предложили определить — кто изображен на фотографии — настоящий человек или лицо, сгенерированное нейросетью StyleGAN2. Участники смогли дать правильный ответ только в 48 % случаев. Это значит, что в случае правильного ответа люди просто случайно угадывали его.

После этого ученые пригласили вторую группу, в которую вошли 219 добровольцев. Этим людям рассказали — как можно отличить дипфейки и предложили то же задание. На этот раз точность распознавания составила уже 59 %.

Параллельно ученые пытались определить, какие эмоции вызывают у испытуемых лица, сгенерированные при помощи искусственного интеллекта. И выяснилось, что эти ненастоящие лица вызывают у людей больше доверия, чем лица настоящих людей.